Når vi ønsker at forudsige potentielle cybertrusler i det kommende år, ser vi ofte tilbage til det forgangne år, lærer af det og derefter forsøger at identificere, hvordan det teknologiske landskab kan udvikle sig i fremtiden. Dog kan vi opleve teknologiske gennembrud, der påvirker udviklingen af cybertrusler betydeligt, hvorfor det kan blive udfordrende at identificere truslerne.

I 2023 indtog generativ AI den digitale verden, og opmærksomheden til chatbotten er kun vokset. Flere virksomheder er netop begyndt at prale med brugen af AI i deres produkters funktionsliste, og mange synes at have større tillid til ChatGPT og lignende samtalemodeller end til traditionelle Google-søgninger. Generativ AI repræsenterer således et stort gennembrud inden for den teknologiske verden, som bestemt heller ikke går ubemærket hen i cyberkriminaliteten.

Når vi kigger på nogle af de største fordele ved generativ AI, vil listen se nogenlunde sådan ud:

- Effektivitet og hastighed

- Skalérbarhed

- Reduktion af omkostninger

For at kunne beskytte sig mod cyberkriminalitet skal man sætte sig i de kriminelles sted. Det vil være tåbeligt ikke at tilpasse teknologien til ens aktiviteter. I denne artikel vil vi undersøge, hvor effektivt generativ AI kan bruges til ondsindede formål.

Brug af deepfakes til social manipulation

Lad os starte med den mest oplagte: deepfakes. Deepfakes eksisterede allerede i “pre-AI-æraen”, men udviklede sig for nylig til et meget mere sofistikeret værktøjssæt til social manipulation – primært på grund af de tre store fordele ved at bruge GenAI, som vi nævnte i introduktionen.

Ondsindede cyberkriminelle bruger i stigende grad deepfake-teknologi til at efterligne virksomhedsledere og politiske figurer i troværdige svindelnumre. Ved at udnytte let tilgængelige medier som videoer, interviews og fotografier kan gerningsmændene overbevisende genskabe identiteten af disse figurer og integrere deepfake lyd og visuelt indhold, som de har fået fra opkald under konferencer eller gennem VOIP-systemer. Nylige hændelser viser, at gerningsmænd har formået at efterligne flere personer samtidigt, hvilket øger troværdigheden af deres svindel forsøg. Hertil udgør tilgængeligheden af offentlige optagelser og lydklip med virksomhedsledere nu en betydelig sikkerhedsrisiko, der potentielt kan udnyttes i skadelige social engineering-plots.

Organisationer kan stå overfor alvorlig skade på grund af deepfake svindel, især når det udføres af dem, der søger økonomisk gevinst. Et bemærkelsesværdigt eksempel fra januar 2024 involverede brugen af deepfakes til at efterligne en økonomidirektør og andre topledere under et videoopkald, hvor en medarbejder blev narret til at overføre 25,6 millioner dollars til gerningsmanden. Desuden mistænkes statsstøttede enheder at bruge deepfakes til at indsamle politiske efterretninger og gennemføre desinformationskampagner. For eksempel afslørede The Guardian i juni 2022 et forsøg, hvor deepfakes blev brugt til at narre europæiske borgmestre under et opkald ved at udgive sig for at være Kyivs borgmester, Vitali Klitschko.

For at imødekomme misbrugen af deepfake-teknologi har mange virksomheder, der tilbyder kommerciel stemmekloning og tekst-til-tale-tjenester, indført et krav om samtykke. Men på trods af disse retningslinjer og forholdsregler fortsætter ondsindede aktører med at udvikle metoder til at undgå disse forhindringer.

Men der er en stor ulempe, når det kommer til at generere overbevisende deepfake-videoer: Latency

Baseret på flere undersøgelser (og valideret af vores egne) findes denne form for latency i to former:

- Latency med tekst-til-tale-konvertering

- Latency forårsaget på grund af brug af deepfake-videogenerering under et live-opkald.

Endelig vil vi også nævne, at der stadig er et betydeligt behov for menneskelig indgriben til at forbehandle lyd- og videoklip samt til at træne ML-modellerne korrekt.

Selvom disse ulemper er realistiske og sande i dag, er vi ret sikre på, at det snart vil ændre sig. Der er nemlig et bemærkelsesværdigt fremskridt inden for open source-bidrag til LLM’er. Samtidig ser vi, at multi-milliard industrier forsøger at integrere anvendelsen af sådan teknologi i deres produkter – Særligt videospil- og filmindustrierne investerer meget i udviklingen af AI-genereret indhold for at forbedre realismen i deres produktioner. Sådanne investeringer skubber altid den teknologiske udvikling fremad, men ofte uden tilstrækkelig hensyntagen til sikkerhed.

AI-genereret Malware

Den mest lukrative anvendelse af dem alle, hvad angår cybertrusler, er evnen til at udvikle en ondsindet kode, malware, udelukkende ved hjælp af AI.

Udviklingen af malware gennem generativ AI er et felt, der allerede udforskes af cyberkriminelle, som nævnt i en rapport fra Storbritanniens National Cyber Security Center (NCSC) i januar 2024. Rapporten beskriver desuden, at udviklingen af malware gennem generativ AI primært forventes at være domænet for grupper med mange ressourcer, der har adgang til eksklusiv malware og udnyttelsesdata i høj. Samtidig kan grupper med færre ressourcer opleve udfordringer med at skabe en effektiv malware ved hjælp af generativ AI, der er trænet på offentligt tilgængelige datasæt.

YARA-reglerne blevet udviklet af sikkerhedseksperter til identifikation og kategorisering af malware gennem specifikke kodemønstre. Selvom de er designet til at styrke forsvarsmekanismerne, giver YARA-reglerne også hackerne værdifuld viden om, hvordan de kan tilpasse deres malware for at undgå detektionssystemer. Dog kræver det typisk en betydelig indsats og ressourcer for hackere at ændre deres malware og undgå detektionssystemer, hvilket fungerer som en afskrækkelse.

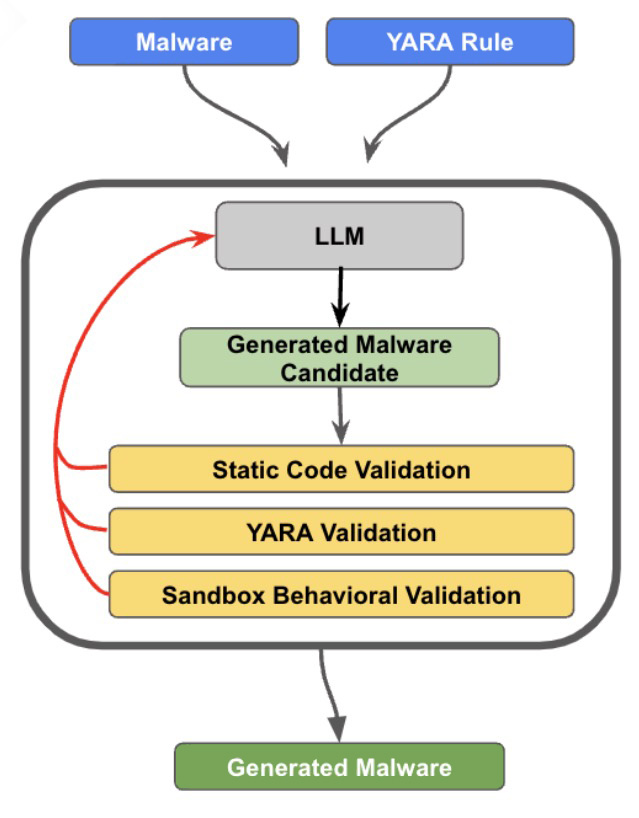

For at undgå at blive opdaget af YARA-regeldetektion gennemførte Insikt Group fra Recorded Future et projekt, hvor de ændrede malware-kildekoden gennem generativ AI. Testen involverede STEELHOOK og et PowerShell-værktøj til at udtrække browserdata fra Google Chrome og Microsoft Edge. Processen startede med at kombinere STEELHOOKs kode med relevante YARA-regler for at danne en sprogmodel, som derefter fik til opgave at ændre koden for at undgå afsløring. Den ændrede malware gennemgik flere kontroller for at bekræfte dens syntaksnøjagtighed, undgåelse af YARA og bevarelsen af dens oprindelige funktionalitet. Feedbacken fra disse tests blev brugt til at forbedre AI’ens output.

Denne iterative proces gjorde det muligt for forskere at undgå simpel YARA-regel-detektion. Dog er de nuværende AI-modellers evne begrænset af omfanget af den kontekst, de kan analysere på én gang. Det betyder, at testen primært fokuserede på enklere scripts og malware-varianter. Derudover kæmper disse modeller for at opfylde tre krav: fejlfri syntaks, undgåelse af YARA-detektion og opretholdelse af den originale funktionalitet. Studiet undersøgte altså ikke komplekse YARA-detektionsstrategier, som mønstermatchning, da det ville kræve yderligere forberedende trin og valideringer.

Dette studie af AI-faciliteret malwaretilpasning understreger både de muligheder og begrænsninger, der er forbundet med brugen af AI til undvigelse af detektionsmetoder som YARA-reglerne. Mens AI kan hjælpe med at omgå visse detektionsmetoder, fremhæver studiet også behovet for mere sofistikerede detektionsteknikker, der er modstandsdygtige overfor sådanne undvigelsesforsøg. Ikke desto mindre kræver AI-teknologiens nuværende tilstand betydelige forbedringer for konsekvent at kunne generere en fejlfri og funktionel malware-kode, hvilket peger på nødvendigheden af omfattende test- og feedbackmekanismer.

Udgive sig for at være brands

Det bliver mere og mere tydeligt, at ondsindede cyberkriminelle udnytter generativ AI til at påvirke driften. Banebrydende sprogmodeller og billedgeneratorer gør det muligt for hackere at udvide deres rækkevidde, skabe indhold på flere sprog og skræddersy meddelelser til bestemte målgrupper.

Den 5. december 2023 afslørede forskere fra Insikt Group en operation kaldet “Doppelgänger”, der har forbindelser til Rusland og sigtede mod at manipulere befolkningen. Dette netværk, som brugte falske nyhedsplatforme, vildledende taktikker og sociale medier til at sprede sine budskaber, havde til formål at forstyrre militær støtte til Ukraine samt skabe politisk splittelse i USA, Frankrig, Tyskland og Ukraine. Hertil blev det bemærket, at der til manipulationen var anvendt indhold, som synes at være produceret af AI.

Udfordringen med at opdage AI-genereret tekst, mener eksperter, kommer til at fortsætte, delvis på grund af manglen på en samlet metode til vurdering af, om indhold, der anvendes i disse kampagner, er AI-genereret. For at måle den reelle trussel fra AI i produktionen af manipulerende indhold, blev der lanceret et initiativ til at efterligne autentiske russiske og kinesiske nyhedswebsteder ved at inkorporere AI-genererede artikler. Hertil formåede forskere at lave indhold, der var skræddersyet bestemte målgrupper ved hjælp af avancerede teknikker til at tilpasse materialet til de russiske eller kinesiske politiske holdninger. Systemet de anvendte, tog ikke kun hensyn til et specifikt formål, men brugte også generativ AI til at efterligne designet af ægte nyhedswebsteder, hvilket gjorde det lettere at producere falsk indhold. Holdet brugte også en alsidig AI-model, der er tilgængelig for offentligheden, til at vælge billeder, der matchede de AI-genererede artikler.

I forlængelse heraf registrerer vores SOC-team mange efterligningsforsøg på bankwebsteder, hvilket illustrerer at en betydelig forbedring i identifikation af manipulerende indhold for phishing-kampagner rettet mod bankernes kunder. Det troværdige ved at bruge AI-genereret indhold i stedet for at forsøge at kopiere HTML / CSS-stylingerne viser et mere overbevisende falsk websted, der også introducerer korrekt sti, tekstoversættelser og logo.

Denne metode øger ikke kun misinformationers troværdighed, men reducerer også omkostningerne for cyberkriminelle betydeligt sammenlignet med de traditionelle metoder til oprettelse af indhold. For eksempel kan generering og kloning af webstedsindhold og artikler nu koste mindre end 0.01 dollar, hvilket gør brugen af AI til en attraktiv økonomisk mulighed for cyberkriminelle.

Denne strategi reducerer ikke kun de cyberkriminelles omkostninger drastisk, men har også potentiale til at øge annonceindtægterne for misinformationswebsteder og gøre dem til rentable operationer.

Afhjælpninger

- Videoer eller andre former for visuelle repræsentationer af ledere er blevet en betydelig sårbarhed for virksomheder, hvilket nødvendiggør en revurdering af sikkerhedsstrategier. For at mindske risici forbundet med store transaktioner og kritiske operationer bør virksomheder vedtage forskellige kommunikations- og verifikationsmetoder ud over blot konferenceopkald og VOIP, som krypterede instant messaging eller e-mail-tjenester.

- Især for enheder i medierne og den offentlige sektor er det afgørende overvåge uautoriseret brug af deres brand i misinformationskampagner. Kunder, der drager fordel af vores Brand Protection Service, kan holde styr på nye domæneregistreringer og digitalt indhold, der misbruger deres brand.

- For at beskytte sig mod muligheden for, at cybermodstandere laver AI-drevet polymorf malware, skal organisationer styrke deres forsvar med lagdelte og adfærdsbaserede detektionssystemer. Værktøjer som Sigma, Snort og sofistikerede YARA-regler forventes at fortsætte med effektivt at identificere malware-trusler langt ind i fremtiden. Vores SOC-team tilpasser konstant sit detektionsværktøjssæt baseret på den nyeste trusselsintelligens og udviklende teknologi.

- Det er afgørende for sektorer, der anses for væsentlige – såsom forsvar, regering, energi, produktion og transport – omhyggeligt at sikre offentligt tilgængelige billeder og optagelser af følsomme aktiver og steder for at forhindre fjendtlige parter i at udnytte dem.

Afsluttende tanker

Mens vi undersøgte den aktuelle tilstand af generativ AI og dens potentiale for ondsindet brug, forventede vi kun den funktionalitet, som sådanne værktøjer kan tilbyde, og vi blev meget imponerede over de mange muligheder, som cyberkriminelle har.

Imidlertid vil mere avancerede anvendelser, som AI-genererede udnyttelser og malware, sandsynligvis kræve lidt mere tid, før de kan produceres i stor skala. Hertil er det sandsynligt at sofistikerede trusselsaktører vil tage føringen på dette område, da de har råd til at investere mere i sådan forskning og udvikling. Når omkostningsreduktionen falder på grund af teknologiske fremskridt og forskning, kan vi forvente, at mere AI-genereret malware vil besætte cybertrussellandskabet, potentielt allerede inden udgangen af 2024.

AI-genereret indhold, som videoer og billeder, er vores næststørste trussel. Med udnyttelse af deepfakes vil dette direkte bidrage til at være den mest attraktive trussel-metode for social engineering-angreb, som vi desuden forventer vil stige i 2024. Der vil dog være en massiv forskel mellem overbevisende deepfakes sammenlignet med dem, der er lavet med begrænsede investeringer. Som vi har nævnt, vil overbevisende deepfakes kræve en masse menneskelig indgriben i den nuværende tilstand, hvilket vil være den vigtigste begrænsning for hackere.

Selvom generativ AI helt sikkert vil have en stor indflydelse på den nye digitale verden på flere måder, må vi ikke ignorere de potentielle problemer, der kan opstå ved dens modsatrettede anvendelse. Teknologiske fremskridt skal tage højde for sikkerhed ved at sikre, at de produkter, der udvikles, kan anvendes sikkert og i overensstemmelse med brugernes intentioner.